The Alignment Handbook - 大语言模型训练最佳实践手册

大家好,又见面了,我是 GitHub 精选君!

背景介绍

在人工智能语言模型的领域,我们每时每刻都在寻求更准确、更有效的模型来理解和生成人类语言。然而,对于如何让这些模型更好地与人类或 AI 的偏好对齐,现有的方法还不够丰富和翔实。在这样的背景下,通过人工反馈进行强化学习(RLHF)的技术造成了很大的反响。但是,尽管这类模型在帮助和安全性方面有显著的提升,但要将其与一系列的偏好进行对齐还是一种相对新颖的想法,现在业界可供参考的资源也很少。

今天要给大家推荐一个 GitHub 开源项目 huggingface/alignment-handbook,该项目在 GitHub 有超过 1.8k Star,用一句话介绍该项目就是:“Robust recipes for to align language models with human and AI preferences”。

项目介绍

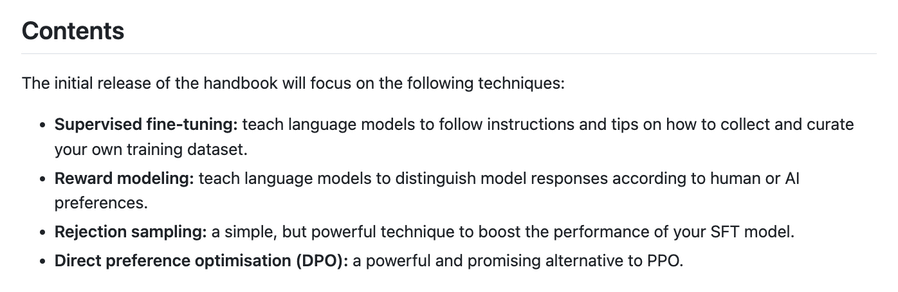

开源项目 The Alignment Handbook 用来帮助人工智能语言模型与人类和 AI 的偏好更好地对齐。项目提供了一整套全面的训练食谱(最佳实践),包含了从模型训练、数据收集到性能测量的每一个步骤,并提供了丰富的示例代码,旨在帮助开发者更有效地训练和使用语言模型。项目重点介绍了监督微调、奖励建模、拒绝采样以及直接偏好优化等技术。

如何使用

首先,我们需要安装 Python,并在 Python 虚拟环境中安装 PyTorch 和其他依赖包。项目提供了详细的安装指南来帮助你进行安装。

conda create -n handbook python=3.10 && conda activate handbook

# 或者使用源码安装

git clone https://github.com/huggingface/alignment-handbook.git

cd ./alignment-handbook/

python -m pip install .

然后,您可以按照 scripts 和 recipes 目录中的指南来训练您的模型。如果您有自己的数据集,我们推荐您按照这里(https://github.com/huggingface/alignment-handbook/tree/main/scripts#fine-tuning-on-your-datasets) 的数据集格式指导训练您的聊天模型。

项目推介

The Alignment Handbook 是由知名机器学习库 huggingface 的团队维护的一个开源项目,包括了全面的训练食谱和大量实用的代码示例,目前已经被广大人工智能和机器学习的研究者和开发者所采用。它的出现真正填补了语言模型偏好对齐的资源空白,具有很高的研究价值和应用前景。同时,此项目受到了不少业内知名人士的高度评价和推荐。在 PyTorch 社区中也被广泛讨论和使用。

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/huggingface/alignment-handbook

开源项目作者:huggingface

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

更多精彩请扫码关注如下公众号。