基于 Python 的 LLM 推断和服务框架

大家好,又见面了,我是 GitHub 精选君!

今天我要介绍的是一个轻量级、易扩展、高性能的大语言模型 (LLM) 推断和服务框架:LightLLM。在大数据和 AI 领域,我们常常会遇到本地资源无法承载大语言模型推断,或者语言模型服务效率低下的问题,那么 LightLLM 就是为了解决这类问题而生的。

LightLLM 在 GitHub 有超过 1.2k Star,是一个基于 Python 的 LLM 推断和服务框架,采用异步协作方式处理 tokenization、模型推断、和 detokenization,大大提高了 GPU 的利用率。LightLLM 包含了诸多特殊设计和优秀特性,包括但不限于 FasterTransformer, TGI, vLLM, 和 FlashAttention。

LightLLM 的特性包括如下:

- 三进程异步协作:tokenization、模型推断、和 detokenization 异步执行,大大提高了 GPU 利用率。

- Nopad (Unpad):提供对多个模型的无填充注意力操作的支持,为处理大长度差异的请求提供了有效办法。

- 动态批处理:实现了动态批处理调度的功能。

- FlashAttention:使用 FlashAttention 来提高推断速度,并且在推断过程中减少 GPU 内存占用。

- Tensor 并行化:使用 Tensor 并行化技术提高推断速度。

- Token Attention:实现了 Token-wise 的 KV 缓存内存管理机制,实现零内存浪费推断。

- 高性能路由器:配合Token Attention 精细管理每个 token 的 GPU 内存,优化系统吞吐量。

- Int8KV 缓存:这个特性将使 token 的容量接近翻倍。

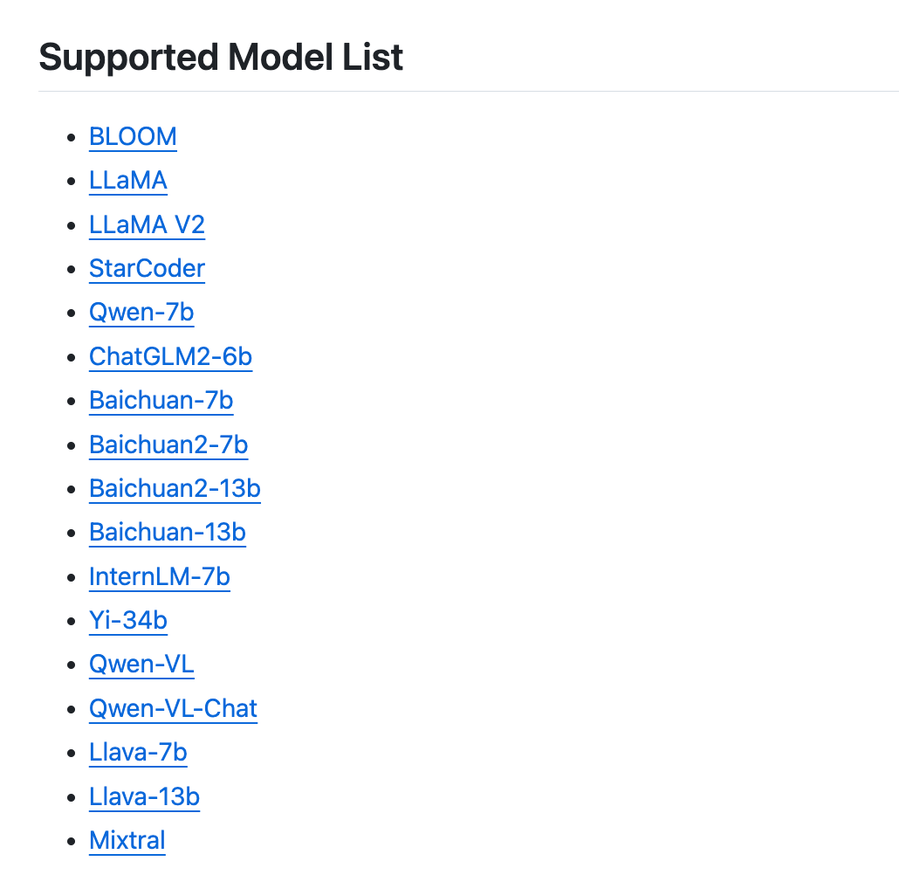

这个项目已经支持众多知名模型,包括 BLOOM,LLaMA,StarCoder,Baichuan,Yi-34b 等等。详细的模型列表如下图所示:

想要使用 LightLLM,你首先需要满足 Pytorch>=1.3, CUDA 11.8, 以及 Python 3.9 的环境要求。在满足前提条件后,可以通过 pip 安装依赖:

pip install -r requirements.txt

同时,你可以使用官方 Docker 容器来更加方便的运行模型。详情步骤你可以参考项目的 README 提供的 Docker 使用指南。

LightLLM 是一款非常活跃的开源项目,在解决大语言模型推断和服务的问题上,无论是设计理念,或者实际表现,都非常出色。如果你在寻找一款可靠、高效的 LLM 推断和服务框架,那么 LightLLM 是你绝对不能错过的选项。

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/ModelTC/lightllm

开源项目作者:ModelTC

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

更多精彩请扫码关注如下公众号。