GitHub 开源项目 NVlabs/VILA 介绍,VILA - a multi-image visual language model with training, inference and evaluation recipe, deployable from cloud to edge (Jetson Orin and laptops)

大家好,又见面了,我是 GitHub 精选君!

背景介绍

今天要给大家推荐一个 GitHub 开源项目 NVlabs/VILA,该项目在 GitHub 有超过 2.1k Star。

一句话介绍该项目:VILA - a multi-image visual language model with training, inference and evaluation recipe, deployable from cloud to edge (Jetson Orin and laptops)

项目介绍

背景介绍: 在数字化日益发展的今天,视频和图片已成为信息传播的重要媒介。然而,理解和分析海量的视觉内容,特别是将图像和文字信息有效结合的能力,对于计算机而言仍然是一个巨大的挑战。这种挑战不仅涉及如何使计算机理解单一图片中的内容,还包括如何让计算机理解和分析视频序列、多图像内容以及图像与文本交织在一起时的复杂信息。传统的视觉语言模型(VLM)多集中于图像与文字的简单配对,并未深入挖掘这两者之间复杂且富有内涵的相互关系,这限制了模型在视频理解、多图像理解方面的能力。

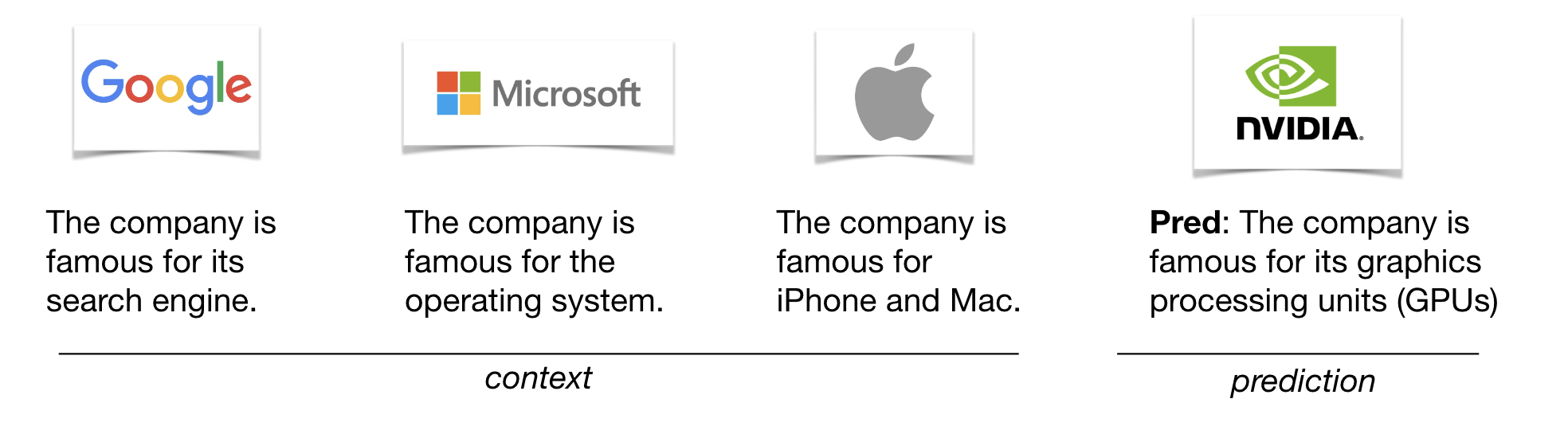

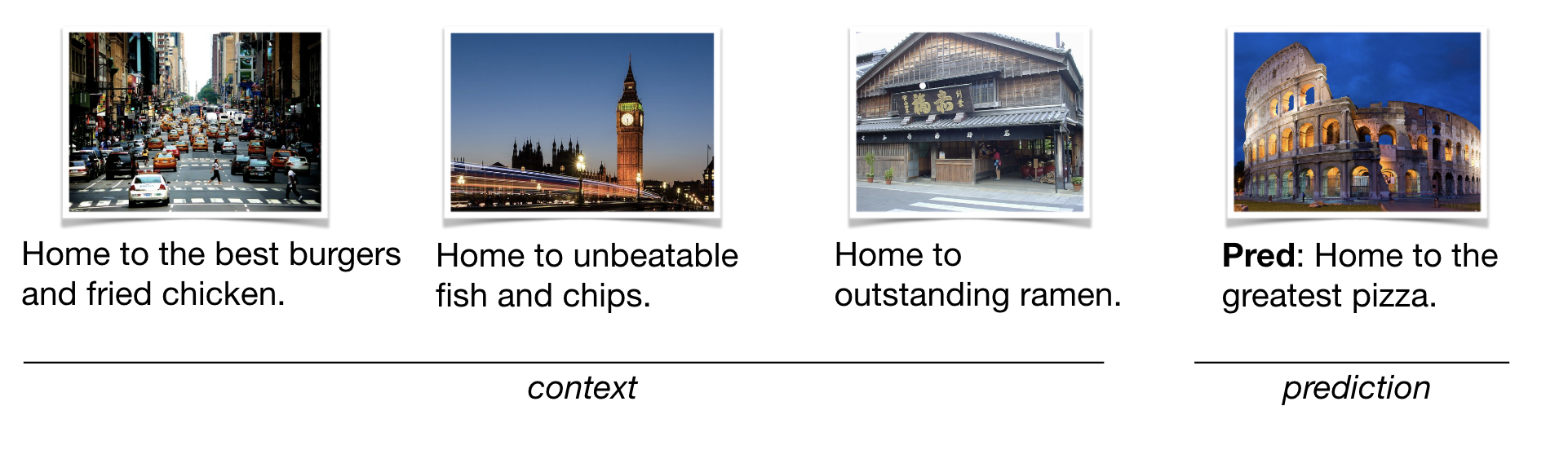

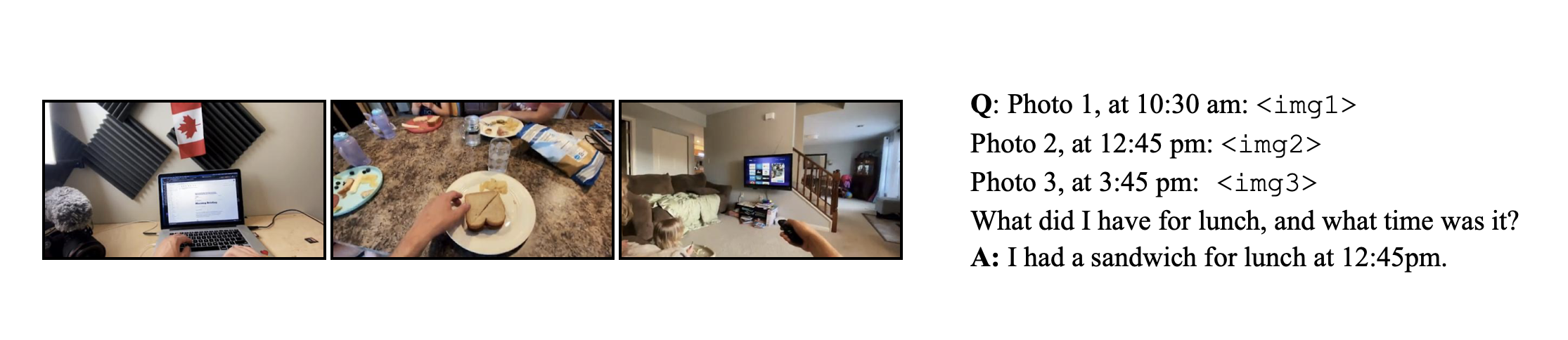

项目介绍: VILA 是一款突破性的多图像视觉语言模型,通过大规模交叉预训练图像-文本数据,实现了对视频理解和多图像理解能力的显著提升。VILA 在边缘设备上部署实现了高效化,利用 AWQ 4bit 量化和 TinyChat 框架,能够在 NVIDIA 的各类 GPU(如 A100、4090、4070 Laptop、Orin、Orin Nano)上高效运行。VILA 的核心创新在于其揭示了图像-文本配对不足以完成高级视觉理解任务,进而提出了图像-文本交织预训练,以及训练过程中对大型语言模型(LLM)的解冻,促进了上下文学习的能力。此外,通过重新融合仅文本指令数据以及标记压缩技术,VILA 不仅显著提高了视频帧的处理能力,还加深了对视频推理、视觉链式思维等能力的理解。

如何使用: 要开始使用 VILA,你可以从相关 GitHub 页面下载训练代码、评估代码以及预训练模型。为了简化部署过程,可以利用 TinyChat 和 AWQ 4bit 量化技术将模型部署到不同的 NVIDIA GPU 上。操作示例和具体的安装步骤请参考 VILA Demo 和 VILA Huggingface。

项目推介: VILA 无疑是一个令人兴奋的开源项目。它不仅在 CVPR 2024 上被接收,更在多个基准测试如 MLVU、MMMU 以及 Video-MME 排行榜上取得了领先的成绩。此外,其在医学视觉语言领域的应用(VILA-M3)也显示出其出色的性能,与其他顶尖模型(如 Llava-Med、Med-Gemini)相提并论,并且完全开源。这些成绩不仅证明了 VILA 的技术先进性和应用潜力,也意味着它已经得到了业界的广泛认可和使用。VILA 的成功案例,包括对视频理解和多图像理解的深入研究,使其成为研究人员和开发者不可或缺的工具之一。

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/NVlabs/VILA

开源项目作者:NVlabs

开源协议:Apache License 2.0

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

更多精彩请扫码关注如下公众号。