DeepSpeed - 微软开源的强大深度学习优化库

大家好,又见面了,我是 GitHub 精选君!

背景介绍

在深度学习领域,我们经常面临着训练大规模语言模型的挑战。这些模型具有数十亿或数万亿个参数,而传统的训练方法在效率和速度上往往表现欠佳。为了解决这个问题,Microsoft 开发了 DeepSpeed,一个易于使用的深度学习优化软件套件,为训练和推理提供了前所未有的规模和速度。

GitHub 开源项目 microsoft/DeepSpeed 在 GitHub 有超过 29.4k Star,用一句话介绍该项目就是:“DeepSpeed is a deep learning optimization library that makes distributed training and inference easy, efficient, and effective.”。

项目介绍

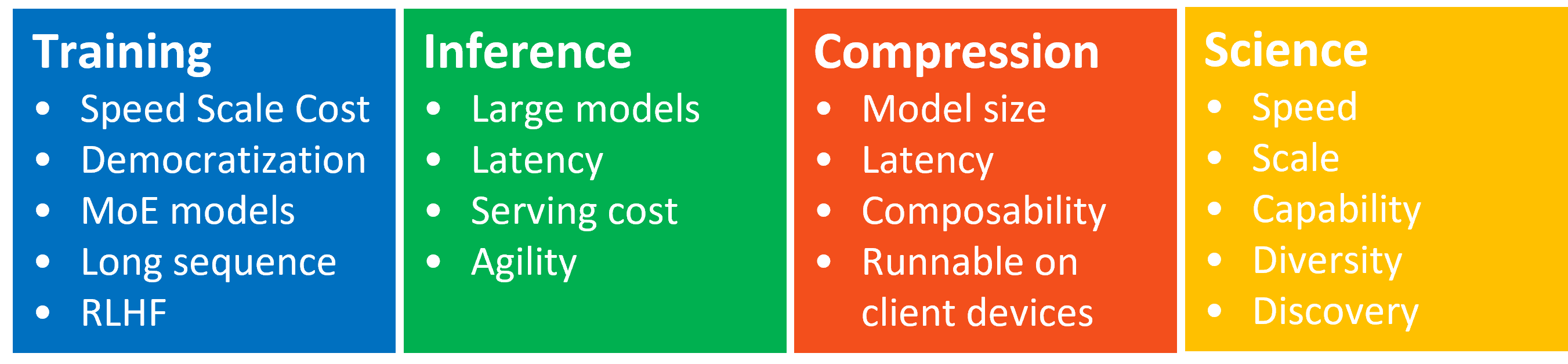

DeepSpeed 致力于解决分布式训练和推理中的性能瓶颈。它提供了丰富的功能和设计,包括以下特点:

1、高效稀疏和密集计算:DeepSpeed 可以处理包含数十亿或数万亿个参数的稀疏或密集模型,实现高效的训练和推理。

2、可伸缩性:DeepSpeed 能够有效地扩展到数千个 GPU,实现出色的系统吞吐量。无论是规模较小的训练任务,还是超大规模的语言模型训练,DeepSpeed 都能轻松胜任。

3、资源受限环境下的训练:DeepSpeed 专为资源受限的 GPU 系统设计,可以在有限的硬件资源下实现高效的训练。

4、灵活易用:DeepSpeed 提供了简单易懂的 API 和命令行工具,使用户能够方便地配置和控制深度学习训练和推理过程。

如何使用

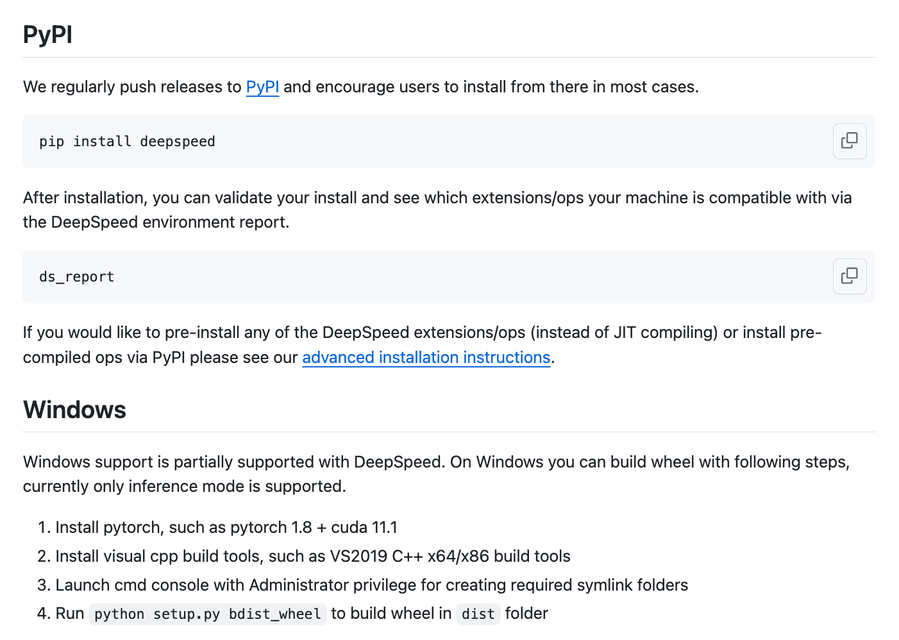

DeepSpeed 的安装和使用非常简单。你可以按照项目 README 中提供的步骤进行安装,并参考文档中的示例代码来进行训练和推理。

以下是一个简单的代码示例:

import deepspeed

# 加载DeepSpeed配置

ds_config = {

"activation_checkpointing": True,

"fp16": {

"enabled": True,

"loss_scale": 0.1,

"initial_scale_power": 16

},

"zero_optimization": {

"stage": 2,

"optimizer": {

"type": "Adam",

"params": {

"lr": 0.001

}

}

}

}

# 初始化DeepSpeed Engine

model, optimizer, _, _ = deepspeed.initialize(

model=model,

optimizer=optimizer,

config_params=ds_config

)

# 在DeepSpeed Engine上训练模型

with deepspeed.training_engine(model, optimizer) as engine:

for batch in dataloader:

# 执行训练步骤

engine.backward(batch)

engine.step()

DeepSpeed 已经用来在下面多个模型上进行训练,其适应性和可扩展性已经得到了充分的验证。

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/microsoft/DeepSpeed

开源项目作者:microsoft

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

更多精彩请扫码关注如下公众号。